ビジョントランスフォーマーを用いた日本語の手話ビデオの認識

工学部 工学科 教授 姜 有宣

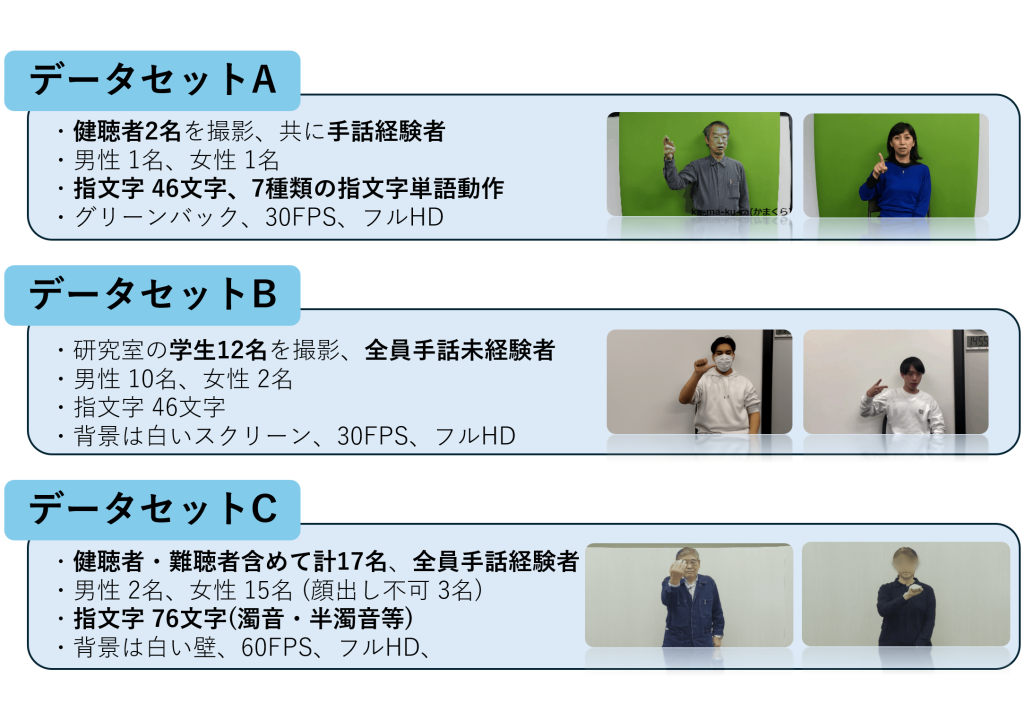

本研究は、日本語の指文字をRGBカメラ映像から高精度に認識することを目的とし、MediaPipeを用いた指の角度特徴量の抽出、Vision Transformer(ViT)などの深層学習モデルの活用、さらに連続動作の分割と認識手法の構築を通じて、非接触・非装着型の指文字認識システムを開発したものである。

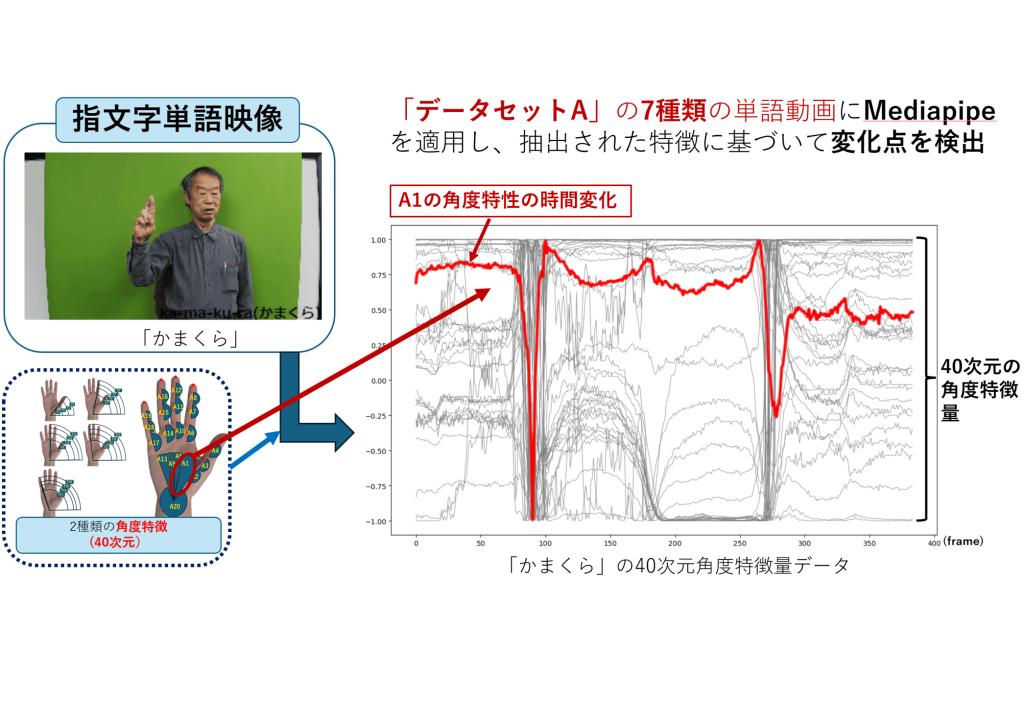

本研究では、MediaPipeを用いて指の関節角度および手全体の傾きを余弦値として算出し、40次元の角度特徴量として定義した。

この特徴量を入力とし、Vision Transformer(ViT)とConvolutional Neural Network(CNN)による日本語指文字認識モデルの比較を行った結果、ViTは99.4%、CNNは99.6%という高い認識精度を記録した。特にViTは構造の柔軟性や将来的な拡張性に優れており、高精度な認識に加えて今後の応用の広がりが期待される点で有望であると評価された。

さらに、単語単位の認識を実現するために、1つの指文字単語映像を文字ごとに分割する変化点検出手法を導入し、効果的なセグメンテーションを実施した。

これにより、分割された各文字動作に対して学習済みViTモデルを適用し、連続する手話動作の中から単語を構成する各文字を正確に認識することが可能となった。

これらの成果により、本研究は日本語指文字認識の実用性を大きく前進させ、聴覚障害者支援や手話通訳システムへの応用、さらにはメタバース空間における新たな文字入力手段としての活用にも貢献する可能性を示した。